Odos dienoraštis pateikia šio potraukio įrodymą. Štai kodėl pokey pramonės naujokai dažnai pasimeta, todėl viskas vyksta taip:

Koks robotas ex ti?

Failas robots.txt arba Rodyklės failas— pirminis tekstinis dokumentas, užkoduotas UTF-8, tinka http, https ir taip pat FTP protokolams. Failas suteikiamas paieškos robotams dėl: kurie puslapiai/failai yra nuskaitomi. Jei faile yra simbolių ne UTF-8, o kitos koduotės, paieškos robotai gali juos neteisingai apdoroti. Taisyklės, pateiktos faile robots.txt, galioja priklausomai nuo prieglobos, protokolo ir prievado numerio, kuriame yra failas.

Failas turi būti įdiegtas šakniniame kataloge pirminio tekstinio dokumento pavidalu ir pasiekiamas adresu: https://site.com.ua/robots.txt.

Kituose failuose įprasta įdėti BOM (baitų eilės žymos) piktogramą. Tai Unikodo simbolis, naudojamas nurodant seką baitais, kai skaitoma informacija. Kodo simbolis yra U+FEFF. Nepaisoma baitų sekos ženklo robots.txt faile.

„Google“ nustatė robots.txt failo dydžio apribojimus – jūs neprivalote įvesti daugiau nei 500 KB.

Garazd, kadangi reikia tam tikrų techninių detalių, robots.txt failas aprašytas Beckus-Naur formoje (BNF). Šiuo atveju peržiūrimos RFC 822 taisyklės.

Analizuodami taisykles iš failo robots.txt, paieškos robotai išves vieną iš trijų instrukcijų:

- privati prieiga: negalima nuskaityti kitų svetainės elementų;

- universali prieiga: viską galima nuskaityti;

- pilna tvora: robotas nieko negali nuskaityti.

Nuskaitydami robots.txt failą, robotai aptiks šių tipų atsakymus:

- 2xx - nuskaitymas buvo sėkmingas;

- 3xx Garso robotas seka duomenų nukreipimą, bet neatmeta kitų įvesties. Dažniausiai yra penki bandymai, kad robotas paimtų 3xx liniją, tada užregistruojama 404 klaida;

- 4xx - Paieškos robotas vertina, kad galite nuskaityti visą svetainę;

- 5xx - yra vertinamas kaip savalaikiai serverio gedimai, nuskaitymas visiškai blokuojamas. Robotas ir toliau slinks per failą, kol atmes kitą įvestį. Google paieškos robotas gali nustatyti, ar skirtingų svetainės puslapių išvestis koreguojama teisingai, ar neteisingai, todėl vietoj 404 atsakymų puslapis gamina 5xx versiją, tokiu atveju puslapis bus Call in with the 404 line code.

Vis dar nežinoma, kaip generuojamas robots.txt failas, kuris nepasiekiamas dėl serverio problemų su interneto prieiga.

Galiausiai reikalingas robots.txt failas

Pavyzdžiui, kartais robotai nemoka pristatyti:

- puslapiai su specialia informacija apie svetainės klientus;

- puslapiai su įvairiomis dalijimosi informacija formomis;

- interneto svetainių veidrodžiai;

- puslapiai su paieškos rezultatais.

Svarbu: kadangi puslapis yra faile robots.txt, aišku, kad jis bus rodomas, jei svetainėje arba išoriniame šaltinyje jame buvo rastas pranešimas.

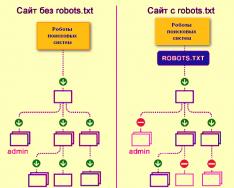

Štai kaip paieškos variklio robotai tikrina svetainę su robots.txt failu arba be jo:

Be robots.txt iš trečiųjų šalių gauta informacija gali būti prarasta ir dėl to nukentėsite jūs ir svetainė.

Štai kaip paieškos sistemų robotas atsisiunčia robots.txt failą:

„Google“ svetainėje nustatė failą robots.txt ir žino svetainės puslapių tikrinimo taisykles

Kaip sukurti failą robots.txt

Naudokite užrašų knygelę, Notepad, Sublime ar bet kurį kitą teksto rengyklę.

User-agent – vizitinė kortelė robotams

User-agent – taisyklė apie tuos robotus, kuriems reikia vadovautis robots.txt faile aprašytomis instrukcijomis. Šiuo metu matomi 302 paieškos robotai

Pakalbėkime apie tuos, kurių robots.txt taisykles nurodome visiems paieškos robotams.

„Google“ pagrindinis robotas yra „Googlebot“. Jei norime apsaugoti ką nors kita, failo įrašas bus toks:

Tokiu atveju visi kiti robotai tikrins turinį pagal savo nurodymus, kaip apdoroti tuščią failą robots.txt.

„Yandex“ pagrindinis robotas yra... „Yandex“:

Kiti specialūs robotai:

- Mediapartners-Google– „AdSense“ paslaugai;

- AdsBot-Google- Patikrinti visos pusės rėmą;

- „YandexImages“.- Yandex.Images indeksavimo priemonė;

- „Googlebot“ vaizdas- Nuotraukoms;

- „YandexMetrika“.- Yandex.Metrica robotas;

- „YandexMedia“.- Robotas, indeksuojantis multimedijos duomenis;

- YaDirectFetcher- Yandex.Direct robotas;

- „Googlebot-Video“.- Vaizdo įrašams;

- Googlebot-Mobile- mobiliajai versijai;

- YandexDirectDyn- Dinaminių reklaminių antraščių generavimas robotu;

- „Yandex“ dienoraščiai- Robotas ieško tinklaraščių, kuriuose indeksuojami įrašai ir komentarai;

- „Yandex Market“.- Yandex.Market robotas;

- „YandexNews“.- Robotas Yandex.Novin;

- „YandexDirect“.— renka informaciją apie Reklamos žiniasklaidos partnerių svetainių turinį, kad būtų išaiškintos jų temos renkantis atitinkamą reklamą;

- „YandexPagechecker“.- mikroženklinimo tikrintuvas;

- „Yandex“ kalendorius- Yandex.Calendar robotas.

Neleisti – nustatykite tikslą

Esame to atsargūs, nes svetainė baigiama tvarkyti, o jūs nenorite, kad ji jokiu būdu būtų atskleista.

Šią taisyklę svarbu žinoti, jei svetainė paruošta, kol jos nesugadino koristuvachai. Deja, daugelis žiniatinklio valdytojų apie tai pamiršta.

užpakalis. Kaip parašyti Disallow taisyklę, kad robotai nežiūrėtų į rekomendacijos datą, o ne į aplanką /papka/:

Ši eilutė blokuoja visų failų su plėtiniais.gif indeksavimą

Leisti – vadovauja robotams

Leisti leidžia nuskaityti bet kurį failą / direktyvą / pusę. Gali būti, bet būtina, kad robotai galėtų matyti tik tuos puslapius, kurie prasidėjo be /catalog, ir uždaryti turinį. Kuriam tipui nustatytas toks derinys:

Leisti ir neleisti taisyklės rūšiuojamos pagal URL priešdėlį (nuo mažiausio iki didžiausio) ir išdėstomos nuosekliai. Jei puslapis tinka keliolika taisyklių, robotas iš surūšiuoto sąrašo pasirenka likusią taisyklę.

Šeimininkas – pasirinkite veidrodinę svetainę

Priegloba yra viena iš privalomų robots.txt taisyklių, ji informuoja „Yandex“ robotą, kad indeksavimui turėtų būti naudojama veidrodinė svetainė.

Svetainės veidrodis – tiksli arba tiksli svetainės kopija, prieinama skirtingais adresais.

Robotas neklaidžios, jei svetainėje yra veidrodžių ir aišku, kad veidrodis nurodytas robots.txt faile. Svetainių adresai turi būti įvesti be http:// priešdėlio; kitu atveju, jei svetainė veikia HTTPS, reikia įvesti https:// priešdėlį.

Kaip parašyti šią taisyklę:

Failo robots.txt pavyzdys, nes svetainė veikia HTTPS protokolu:

Svetainės planas – medicinos svetainės žemėlapis

Svetainės schema informuoja robotus, kad visi svetainės URL, kuriuos reikia indeksuoti, yra adresu http://site.ua/sitemap.xml. Apžiūros metu robotas žinos, kokie pakeitimai buvo atlikti šiame faile, ir greitai atnaujins informaciją apie svetainę paieškos sistemos duomenų bazėse.

Crawl-delay – silpnų serverių chronometras

Tikrinimo delsa yra parametras, leidžiantis nurodyti laikotarpį, per kurį bus tikrinami svetainės puslapiai. Ši taisyklė yra aktualesnė, jei turite silpną serverį. Tokiu atveju gali kilti didelių problemų dėl paieškos robotų diegimo svetainės pusėje. Šis parametras pasikeičia per kelias sekundes.

Clean-param – rūpinkitės turiniu, kuris pasikartoja.

„Clean-param“ padeda susidoroti su gavimo parametrais, kad būtų išvengta turinio, kuris gali būti pasiekiamas skirtingais dinaminiais adresais (iš sklaidos kanalų), dubliavimo. Tokie adresai atsiranda dėl to, kad svetainėje skiriasi rūšiavimas, seansų ID ir kt.

Gali būti, kad pusė yra prieinama šiais adresais:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

Šiuo atveju failas robots.txt atrodo taip:

Čia ref nurodo, kad pranešimas išsiųstas, tai parašyta pačiame puslapyje, o tada nurodomas adresas.

Prieš pereidami prie nuorodos failo, turite žinoti tam tikrus ženklus, kurie bus taikomi rašant robots.txt failą.

Simboliai faile robots.txt

Pagrindiniai failo simboliai yra "/, *, $, #".

Dėl tolimesnės pagalbos pasvirasis brūkšnys "/" Rodome, ką norime padengti robotais. Pavyzdžiui, jei taisyklė Neleisti turi vieną pasvirąjį brūkšnį, ji neleidžia tikrinti visos svetainės. Naudodami du pasviruosius brūkšnius galite užblokuoti bet kurio kito katalogo nuskaitymą, pavyzdžiui: /catalog/.

Toks įrašas reikštų, kad mes nuskaitytume visą turinį į katalogo katalogą, o jei parašytume /catalog, blokuotume visus įrašus svetainėje, kurie prasideda raide /catalog.

Zirochka "*" reiškia bet kokią failo simbolių seką. Jis turėtų būti dedamas po odos taisyklės.

Šis įrašas rodo, kad ne visi robotai yra kalti, kad aplanke /catalog/ indeksuoja failus su plėtiniu .gif

dolerio ženklas «$» apsuptas žvaigždės ženklo. Jei reikia apsaugoti visą katalogo aplanką, kitaip negalite apsaugoti URL, pvz., /catalog, indekso failo įrašas bus toks:

Įveskite „#“ Vikoristui už komentarus, kad žiniatinklio valdytojas atima iš kitų žiniatinklio valdytojų. Robotas neatsako už svetainės skenavimą.

Pavyzdžiui:

Kaip atrodo idealus robots.txt

Failas įkeliamas į svetainę indeksuoti, pagrindinis kompiuteris užregistruojamas ir pateikiamas svetainės žemėlapis, kad paieškos sistemos galėtų gauti adresus, kurie gali būti indeksuojami. „Yandex“ taisyklės yra aiškiai nurodytos, nes ne visi robotai supranta pagrindinio kompiuterio instrukcijas.

Tiesiog neskubėkite kopijuoti failo sau – kiekviena svetainė gali turėti unikalias taisykles, priklausomai nuo svetainės tipo ir TVS. Todėl pildydami robots.txt failą turėtumėte atsiminti visas taisykles.

Kaip patikrinti failą robots.txt

Jei norite įsitikinti, kad tinkamai užpildėte robots.txt failą, patikrinkite jį žiniatinklio valdytojo įrankiuose Google ir „Yandex. Tiesiog įveskite išvesties kodą į robots.txt failą pateikimo formoje ir nurodykite svetainę, kuri yra tikrinama.

Kaip išsaugoti failą robots.txt

Dažnai pildant rodyklės failą išskyros leidžiamos, ir tai nutinka dėl ypatingos nepagarbos ar skubėjimo. Keletą kartų mažesnis už atleidimo diagramą, kurią išmokau praktiškai.

2. Kelių aplankų/katalogų įrašymas vienoje Neleisti instrukcijoje:

Toks įrašas gali suklaidinti garso robotus, jie gali nesuprasti, kad jų pačių nereikėtų indeksuoti: ar aš paleisiu aplanką, ar palieku jį, reikia atidžiai parašyti odos taisyklę.

3. Pats failas gali būti vadinamas tik robots.txt, o ne Robots.txt, ROBOTS.TXT ar kokiu kitu būdu.

4. Vartotojo-agento taisyklės negaliojančia negalima – reikia pasakyti, kuris robotas atsakingas už faile įrašytų taisyklių pakeitimą.

5. Dydžių tvirtinimas iš failo (brūkšniai, žvaigždutės).

6. Puslapių, kurie nebūtinai turi būti indekse, įtraukimas į failą.

Nestandartinis robots.txt

Be tiesioginių funkcijų, rodyklės failas gali tapti kūrybiškumo šaltiniu ir būdu ieškant naujų savanorių.

Tai svetainė, kurioje pats robots.txt yra nedidelė svetainė su darbo elementais ir reklaminiu bloku.

Kaip padirbinių ieškojimo priemonė, failą daugiausia tvarko SEO agentūros. Kas dar gali sužinoti apie jūsų svajonę? :)

Ir „Google“ saugo specialų failą žmonės.txt Kad neleistumėte minčių apie fahivtų diskriminaciją dėl jų odos ir mėsos.

Visnovki

Naudodami Robots.txt galite duoti nurodymus ieškoti robotų, reklamuoti save, savo prekės ženklą ir pokštų specialistus. Tai puiki laukas eksperimentams. Golovny, atsiminkite tinkamą failų užpildymą ir standartinį valymą.

Taisyklės, jos dvokia direktyvomis, dvokia instrukcijomis į failą robots.txt:

- „User-agent“ yra taisyklė apie tuos robotus, kurie turi laikytis robots.txt aprašytų instrukcijų.

- Neleisti reiškia rekomendaciją, kad pačios informacijos negalima nuskaityti.

- Svetainės schema informuoja robotus, kad visi svetainės URL, kuriuos reikia indeksuoti, yra adresu http://site.ua/sitemap.xml.

- Šeimininkas informuoja „Yandex“ robotą, kad reikia samdyti veidrodinę svetainę indeksavimui.

- Leisti leidžia nuskaityti bet kurį failą / direktyvą / pusę.

Ženklai sulankstant robots.txt:

- Dolerio ženklas „$“ yra apsuptas žvaigždės ženklu.

- Po pasviruoju brūkšniu „/“ parodome, ką norime paslėpti nuo robotų aptikimo.

- Žvaigždė „*“ reiškia bet kokią failo simbolių seką. Jis turėtų būti dedamas po odos taisyklės.

- Maiša „#“ naudojama pažymėti komentarus, kuriuos žiniatinklio valdytojas rašo sau ar kitiems žiniatinklio valdytojams.

Išmintingai sutvarkykite indekso failą – ir svetainė bus matoma ateityje.

Skaitymo valanda: 7 hvilinai

Beveik kiekviename projekte, kuris ateina pas mus audituoti ar tikrinti, yra neteisingas robots.txt failas ir dažnai visą dieną. Taigi atrodo, kad kuriant failą kiekvienas vadovaujasi savo fantazija, o ne taisyklėmis. Išsiaiškinkime, kaip tinkamai sulankstyti šį failą, kad paieškos robotai galėtų efektyviai su juo dirbti.

Ar vis tiek reikia pakoreguoti robots.txt?

Robotai.txt- šis failas yra šaknies katalozės svetainėje, apie kurią praneša paieškos variklio robotas, prie kurių svetainės skilčių ir puslapių jiems gali būti uždrausta prieiga, bet prie kurių nėra prieigos.

Robots.txt koregavimas yra svarbi paieškos sistemų dalis, teisingas robotų koregavimas taip pat padidina svetainės produktyvumą. Robots.txt buvimas neleidžia paieškos sistemoms tikrinti ir indeksuoti svetainės, kitaip, jei neturite šio failo, galite susidurti su dviem problemomis:

Paieškos robotas nuskaito visą svetainę, todėl „iššluoja“ nuskaitymo biudžetą. Nuskaitymo biudžetas yra tiek svetainių, kiek paieškos robotas gali naršyti per vieną valandą.

Be robotų failo paieškos variklis neleidžia pasiekti nespalvotų puslapių, iki šimtų puslapių, kurie naudojami TVS administravimui. Jis juos indeksuoja, o jei nueisite į tinkamus puslapius dešinėje, kuriuose pateikiami svarbiausio turinio leidėjams pristatymai, nuskaitymo biudžetas baigsis.

Indeksas gali naudoti svetainės prisijungimo puslapį ir kitus administratoriaus išteklius, kad užpuolikas galėtų lengvai juos pasiekti ir svetainėje įvykdyti DDoS ataką arba kenkėjišką programą.

Kaip ieškoti robotų, norint atsisiųsti svetainę naudojant robots.txt ir be jo:

Robots.txt sintaksė

Pirmiausia pradėkite suprasti sintaksę ir tinkinkite robots.txt, atsižvelgdami į tai, kaip atrodo „idealus failas“:

Ale ne varto razu z yogo zastosovuvati. Kiekvienai svetainei dažniausiai reikia turėti savo koregavimus, nes visi turime skirtingą svetainės struktūrą, skirtingą TVS. Paimkime odos direktyvą eilės tvarka.

Vartotojo atstovas

User-agent – reiškia paieškos robotą, kuris turi vykdyti faile aprašytas instrukcijas. Jei reikia grįžti prie visų iš karto, pasirodys piktograma *. Taip pat galite pereiti prie dainuojančio garso roboto. Pavyzdžiui, „Yandex“ ir „Google“:

Papildomam direktyvos tikslui robotas supranta, kurie failai ir aplankai, kuriuos reikia indeksuoti, yra užblokuoti. Jei norite, kad visa svetainė būtų atidaryta indeksavimui, palikite Neleisti reikšmę tuščią. Norėdami priimti visą svetainės turinį po Neleisti, įdėkite „/“.

Galime užblokuoti prieigą prie dainų aplanko, failo ar failo plėtinio. Mūsų programa uždaro visus paieškos variklius, blokuoja prieigą prie bitrix, paieškos ir pdf aplankų.

Leisti

Leisti atidaryti „Primus“, kad būtų galima indeksuoti puslapius ir svetainės dalis. Programoje pereiname prie Google paieškos robotų, blokuojančių prieigą prie aplanko bitrix, paieškos ir pdf plėtinio. „Bitrix“ aplanke atidarome 3 aplankus indeksavimui: komponentai, js, įrankiai.

Šeimininkas – veidrodinė svetainė

Veidrodinė svetainė yra pagrindinės svetainės kopija. Veidrodžiai naudojami įvairiems tikslams: pakeisti adresą, saugumą, sumažinti srautą serveryje ir kt.

Šeimininkas yra viena iš svarbiausių taisyklių. Jei ši taisyklė bus parašyta, robotas supras, kad jis bus priimtas indeksuoti iš svetainės veidrodžių. Ši direktyva reikalinga Yandex ir Mail.ru robotams. Kiti robotai paprastai ignoruojami. Šeimininkas turi būti registruotas tik vieną kartą!

„https://“ ir „http://“ protokolų robots.txt failo sintaksė skirsis.

Svetainės schema – svetainės schema

Svetainės žemėlapis yra svetainės naršymo forma, naudojama informuoti paieškos sistemas apie naujus puslapius. Vadovaudamiesi papildoma svetainės schemos direktyva, mes „prievarta“ parodome robotui, kad žemėlapis buvo pašalintas.

Simboliai faile robots.txt

Failo simboliai yra: „/, *, $, #“.

Proceso efektyvumo tikrinimas pakoregavus robots.txt

Įdėję Robots.txt į savo svetainę, turite jį pridėti ir patvirtinti su „Yandex“ ir „Google“ žiniatinklio valdytoju.

„Yandex“ patvirtinimas:

- Sekti instrukcijas.

- Pasirinkite: Koreguotas indeksavimas – robots.txt analizė.

Google patikrinimas:

- Sekti instrukcijas.

- Pasirinkite: Nuskaityti – robots.txt failo tikrinimo įrankis.

Tokiu būdu galite patikrinti, ar faile robots.txt nėra pakeitimų, ir, jei reikia, atlikti reikiamus koregavimus.

- Vietoj failo reikia rašyti didžiosiomis raidėmis.

- Neleisti direktyva reikalauja nurodyti bent vieną failą arba katalogą.

- „User-agent“ eilutė neturi būti tuščia.

- Vartotojo agentas visada gali būti prieš Disallow.

- Nepamirškite įtraukti pasvirojo brūkšnio, jei reikia apsaugoti katalogą nuo indeksavimo.

- Prieš įkeldami failą į serverį, turite patikrinti, ar jame nėra sintaksės ir rašybos klaidų.

Sėkmės tau!

3 failo Robots.txt kūrimo ir koregavimo metodų vaizdo apžvalga

Išleidome naują knygą „Turinio rinkodara socialinėje žiniasklaidoje: kaip patekti į išankstinio mokėtojų vadovus ir supainioti juos su savo prekės ženklu“.

„Host“ direktyva yra komanda arba taisyklė, kuri informuoja paieškos variklį apie svarbius dalykus (su www arba be jo). Atrodo, kad failo pagrindinio kompiuterio direktyva priskirta išskirtinai „Yandex.

Dažnai reikia užtikrinti, kad paieškos sistema neindeksuotų jūsų veidrodinės svetainės puslapių. Pavyzdžiui, išteklius yra viename serveryje, tačiau internete jis yra identiškas domeno pavadinimui, kuris yra atsakingas už paieškos rezultatų indeksavimą ir rodymą.

„Yandex“ paieškos robotai apeina svetainių puses ir įtraukia surinktą informaciją į duomenų bazę, neatsižvelgdami į dabartinį tvarkaraštį. Indeksavimo proceso metu problemos iškyla savaime, kurią pusę reikia apdoroti. Pavyzdžiui, robotai turėtų vengti įvairių forumų, paieškos sistemų, katalogų ir kitų išteklių, indeksuoti be painiavos. Tą patį smarvę galima rasti pagrindinėje svetainėje ir veidrodyje. Pirmieji skatina indeksavimą, kiti – ne. Procesas dažnai kenčia nuo problemų. Centre galite naudoti pagrindinio kompiuterio direktyvą Robots.txt faile.

Čia yra reikalingas failas Robots.txt

Robotai yra tipiškas tekstinis failas. Galite sukurti jį naudodami „Notepad“; galite dirbti su juo (atidaryti ir redaguoti informaciją) naudodami „Notepad++“ teksto rengyklę. Failo poreikį optimizuojant žiniatinklio išteklius lemia keli veiksniai:

- Jei bus paskelbtas Robots.txt failas, svetainė bus nuolat lankoma per garso aparatų robotus.

- Akivaizdu, kad visi puslapiai ir veidrodinės svetainės bus indeksuojami.

Indeksavimas bus daug greitesnis, o jei nustatymai bus įdiegti neteisingai, galite pasiklysti „Google“ ir „Yandex“ paieškos rezultatuose.

Kaip formatuoti pagrindinio kompiuterio direktyvą Robots.txt faile

Robotų faile yra direktyva „Host“ – instrukcijos paieškos varikliui apie pagrindinę svetainę ir veidrodį.

Direktyva parašyta tokia forma: Host: [ne kalbos praleidimas] [reikšmė] [ne kalbos praleidimas]. Vadovaujantis nurodymų rašymo taisyklėmis, reikia atlikti šiuos veiksmus:

- HTTPS protokolo pagrindinio kompiuterio direktyva palaiko šifravimą. Tai turi būti ištaisyta, nes prieigą prie veidrodžio riboja pavogtas kanalas.

- Domeno pavadinimas, kuris nėra IP adresas, taip pat žiniatinklio šaltinio prievado numeris.

Teisingai sudaryta direktyva, leidžianti žiniatinklio valdytojui reikšti garso mašinoms de smut dzerkalo. Kitus gerbs kiti, todėl jie nebus indeksuojami. Paprastai veidrodžius galima atskirti pagal santrumpos www buvimą ar nebuvimą. Kadangi korespondentas net neatspindėjo žiniatinklio išteklių, naudojamų „Host“ pagalba, „Yandex“ paieškos sistema buvo geriausias žiniatinklio valdytojo informacijos šaltinis. Tas pats pranešimas bus išsiųstas, jei robotų faile yra ypač jautri pagrindinio kompiuterio direktyva.

Reikšmė, de golovne dzerkalo svetainė yra įmanoma per paieškos sistemą. Paieškos eilutėje turite įvesti ištekliaus adresą ir pažiūrėti rezultatus: svetainė su www prieš domeną adreso eilutėje ir galvos domenas.

Jei išteklius nerodomas rodinio pusėje, vartotojai gali savarankiškai atpažinti jį kaip galvos veidrodį, pereidami į antrinę Yandex.Webmaster skiltį. Kadangi žiniatinklio valdytojas turi užtikrinti, kad svetainės domeno pavadinimas nepaklystų į www, prieglobos serveris jo neturi nurodyti.

Daugelis žiniatinklio meistrų naudoja kirilicos domenus kaip papildomus savo svetainių veidrodžius. Tačiau pagrindinio kompiuterio direktyva nepalaiko kirilicos. Šiuo tikslu būtina dubliuoti žodžius lotynų kalba, kad juos būtų galima lengvai atpažinti nukopijavus svetainės adresą iš adreso eilutės.

Priegloba faile Robotai

Pagrindinis šios direktyvos tikslas yra išspręsti daugumą problemų iš pasikartojančių pusių. Būtina reitinguoti „Host“, nes žiniatinklio šaltinis yra skirtas Rusijos auditorijai ir, matyt, svetainės rūšiavimą gali atlikti „Yandex“ sistema.

Ne visos garso sistemos palaiko pagrindinio kompiuterio direktyvą. Funkcija pasiekiama tik „Yandex. Tačiau nėra garantijos, kad domenas bus priskirtas kaip veidrodinis vaizdas, tačiau, kaip sako pati „Yandex“, pirmenybė visada bus prarasta vardams, nurodytiems pagrindiniame kompiuteryje.

Kad paieškos sistemos tinkamai nuskaitytų informaciją apdorodamos robots.txt failą, reikia įtraukti direktyvą Host į atitinkamą grupę, kuri prasideda po User-Agent. Tačiau robotai gali vikorizuoti „Host“ nepaisant to, kad direktyva yra įrašyta pagal šalies taisykles, jei tik ji yra skerspjūvio.

Išleidome naują knygą „Turinio rinkodara socialinėje žiniasklaidoje: kaip patekti į išankstinio mokėtojų vadovus ir supainioti juos su savo prekės ženklu“.

Robots.txt yra tekstinis failas, kuriame yra paieškos robotų rodiniai, padedantys indeksuoti portalo puslapius.

Daugiau vaizdo įrašų mūsų kanale – mokykitės internetinės rinkodaros iš SEMANTICA

![]()

Atskleiskite, kad išvykote į salą pasiimti savo daiktų. Jūs piešiate žemėlapį. Ten nurodytas maršrutas: „Eik į didįjį kelmą. Pradėkite uždirbdami 10 kronų prie išėjimo, tada eikite į lygį. Pasukite dešine, rasite pečerą.

Tse - vkazivki. Sekdami jais, einate maršrutu ir randate lobius. Apytiksliai paieškos robotas veikia, kai pradeda indeksuoti svetainę ar pusę. Turėtumėte žinoti robots.txt failą. Visi žino, kuriuos puslapius reikia indeksuoti, o kuriuos ne. Ir, vykdydami šias komandas, apeinate portalą ir įtraukite jo puslapius į indeksą.

Kodėl jums reikia robots.txt?

Jie pradeda lankytis svetainėse ir indekso puslapiuose po to, kai svetainė paprašo prieglobos ir užregistruoto DNS. Svarbu nustoti dirbti, net jei neturite jokių techninių failų. Robotai nurodinėja pokštininkus, kad naršydami svetainėje reikia išsaugoti joje turimus parametrus.

Dėl robots.txt failo gali kilti problemų dėl svetainės tikrinimo greičio ir svetainės buvimo indekse. Jei failas nebus tinkamai sukonfigūruotas, iš indekso gali būti įtrauktos svarbios išteklių dalys ir gali būti nereikalingų puslapių.

Visa tai sukelia nutekėjimo problemų.

Pažiūrėkime į ataskaitą, kad pamatytumėte, kokie intarpai yra šiame faile ir kaip jie veikia roboto elgesį jūsų svetainėje.

Yak zrobiti robots.txt

Pirmiausia patikrinkite, kokį failą turite.

Įveskite svetainės adresą naršyklės adreso juostoje ir failo pavadinimą pasviruoju brūkšniu, pvz., https://www.xxxxx.ru/robots.txt

Jei failas yra, ekrane pasirodys parametrų sąrašas.

Faile nėra:

- Failas sukurtas naudojant pagrindinį teksto rengyklę, pvz., Notepad arba Notepad++.

- Turite įdiegti roboto pavadinimą, plėtinys.txt. Įveskite duomenis pagal priimtus projektavimo standartus.

- Galite patikrinti papildomų paslaugų, pvz., „Yandex“ žiniatinklio valdytojo, pranašumų. Ten turite pasirinkti elementą „Analizuoti robots.txt“ skiltyje „Įrankiai“ ir užpildyti raginimus.

- Kai failas bus paruoštas, įkelkite jį į pagrindinį svetainės katalogą.

Nustatymo taisyklės

Jokeriai turi ne vieną robotą. Kai kurie robotai indeksuoja tik tekstinį turinį, o robotai tik grafinį turinį. Net pačiose garso sistemose vikšrinių robotų konstrukcija gali skirtis. Sulankstant dildę būtina ją pritvirtinti.

Jų operatoriai gali nepaisyti kai kurių taisyklių, pavyzdžiui, GoogleBot nereaguoja į informaciją apie tuos, kurie atspindi svetainę galvoje. Apskritai smarvė pagaunama ir saugoma su byla.

Failo sintaksė

Dokumento parametrai: roboto pavadinimas „User-agent“, direktyvos: atskira nuosavybė „Allow“ ir saugumas „Disallow“.

Yra dvi pagrindinės paieškos sistemos: „Yandex“ ir „Google“ Akivaizdu, kad kuriant svetainę svarbu pasinaudoti abiem.

Įrašų kūrimo formatas atrodo taip, kad parodytumėte pagarbą laukuose ir tuščiose eilutėse.

Vartotojo agento direktyva

Robotas ieško įrašų, prasidedančių vartotojo agentu, ir yra paieškos roboto pavadinimo įrašai. Nors tai nenurodyta, svarbu, kad roboto prieiga nebūtų ribojama.

Direktyvos Neleisti ir Leisti

Jei reikia blokuoti indeksavimą iš robots.txt, naudokite Neleisti. Tai padės apriboti roboto prieigą prie svetainės ar įvairių skyrių.

Kadangi robots.txt neatitinka tos pačios „Disallow“ direktyvos, kuri apsaugo, svarbu, kad būtų leidžiama indeksuoti visą svetainę. Zazvichiy zaboroni yra skiriami po odos roboto okremo.

Visa informacija, įvesta po # piktogramos, aparatas nelaikomas komentarais.

Leisti blokuoti, kad būtų suteikta prieiga.

Žvaigždės simbolis naudojamas kaip trumpinys tiems, dėl kurių visi nerimauja: Vartotojo agentas: *.

Tačiau ši parinktis reiškia visišką draudimą indeksuoti visiems.

Pažiūrėsiu į tvorą, o ne į dainuojamą aplanką-katalogas

Norėdami užblokuoti vieną failą, turite įvesti šį absoliutų kelią

Svetainės schema, pagrindinio kompiuterio nurodymai

„Yandex“ įprasta sakyti, kad kaip veidrodį norite jį atpažinti kaip šlamštą. O Google, kaip prisimename, jį ignoruoja. Kadangi veidrodžių nėra, tiesiog atkreipkite dėmesį, kaip svarbu teisingai parašyti savo svetainės pavadinimą su www arba be jo.

Clean-param direktyva

Jie gali būti užšaldyti, jei tinklalapio puslapių URL yra pakeisti besikeičiančius parametrus, bet ne sujungti į juos (tai gali būti bendraautorių, nukreipėjų id).

Pavyzdžiui, puslapių adresas „ref“ nurodo srauto tikslą. Atkreipkite dėmesį, kad geriausių pardavėjų svetainėje yra ženklų. Visiems klientams puslapis bus toks pat.

Darbus galima pateikti internetu, informacija nesikartos. Tai sumažins serverio apkrovą.

Nuskaitymo delsos direktyva

Be to, galite nustatyti, kokiu dažnumu robotas pritraukia puslapius analizei. Ši komanda sustos, jei revantage serveris nurodys, kad reikia paspartinti apėjimo procesą.

Robots.txt užklausos

- Failas nepasiekiamas šakniniame kataloge. Didžiausias robotas nejuokaus ir nemeluos.

- Pavadinimo raidės gali būti mažos lotyniškos.

Pavadinime yra užrašas, kartais prie galo pridedi S raidę ir parašai robotas. - Neįmanoma pakeisti kirilicos simbolių faile robots.txt. Jei reikia įvesti domeną rusų kalba, nurodykite formatą naudodami specialų Punycode formatą.

- Tai domenų vardų konvertavimo į ASCII simbolių seką metodas. Tam galite greitai naudoti specialius keitiklius.

Kodas atrodo taip:

site.rf = xn--80aswg.xn--p1ai

Papildomą informaciją, kuri turėtų būti paslėpta robotų txt faile ir pritaikyta pagal Google ir Yandex paieškos sistemas, rasite papildomuose dokumentuose. Skirtingiems cm jie gali turėti savo ypatybes, tačiau jie skirsis.

be komentarųFailas robots.txt sukurtas specialiai paieškos robotams, kad jie žinotų, kur eiti ir indeksuoti, o kur įvestis blokuojama. Jei jį nustatysite neteisingai, galite per mažai laiko praleisti ieškodami arba nieko nedarysite.

Kad išvengtumėte problemų su straipsnių indeksavimu ir indeksavimu, turite žinoti, kaip sukurti robotų txt visoms paieškos sistemoms. Tai užtruks tik valandą, bet po to būsite ramūs.

Interneto meistrai bandė išsiversti be jo (dažniausiai iš pradžių dėl nežinojimo). Viena vertus, tai protinga pradedantiesiems – taip tikrai neužblokuosite reikiamos informacijos iš paieškos robotų. Kita vertus, šis mažas failas apsaugo duomenis ir neleidžia šiukšliadėžėms peržiūrėti informaciją svetainėje.

Rekomenduoju naujiems tinklaraštininkams naudoti šablonus. Pvz., „WordPress“ skirtas robots txt šablonas. Pagerinkite ir patobulinkite savo svetainę.

Nešifruota reikšmė:

- Vartotojo agentas: * – Jūs esate tiesiogiai prisijungę prie visų paieškos sistemų, „Yandex“ – tik prie „Yandex.

- Neleisti: išvardija aplankus ir failus, užblokuotus indeksuoti

- Priegloba – įveskite savo svetainės pavadinimą be www.

- Svetainės schema: įkelti į XML svetainės schemą.

Įdėkite failą į šakninį svetainės katalogą naudodami „Filezilla“ arba per prieglobos serverio svetainę. Siųsti į pagrindinį katalogą, kad jį būtų galima pristatyti: your_site.ru/robots.txt

Tai ypač aktualu tiems, kurie naudoja CNC (instrukcija rašoma žodžiais, bet ne p=333). Viskas, ką jums reikia padaryti, tai eiti į Nustatymai – Pašto pavadinimas, pasirinkti apatinę parinktį ir lauke įrašyti /%postname%.

Aktoriai raginami kuo greičiau patiems sukurti šį failą:

Norėdami pradėti, kompiuteryje sukurkite bloknotą ir pavadinkite jį robotais (nekeiskite didžiųjų raidžių). Pavyzdžiui, koreguoti savo dydį nebūtina viršyti 500 kb.

Vartotojo atstovas- Paieškos sistemos pavadinimas (Yandex, Googlebot, StackRambler). Jei nori pykti ant visų iš karto, įdėk žvaigždutę *

Ir tada, jei reikia pagalbos, nurodykite puslapius ar aplankus, kurių šiame darbe negalima indeksuoti Neleisti:

Iš pradžių buvo pertvarkyti trys katalogai, įskaitant konkretų failą.

Norėdami leisti viską indeksuoti, turite parašyti:

Vartotojo atstovas: *

Neleisti:

„Yandex“ ir „Google“ robots.txt nustatymas

„Yandex Privaloma pridėti pagrindinio kompiuterio direktyvą, kad nebūtų pasikartojančių puslapių. Šį žodį supranta tik „Yandex“ robotas, todėl įrašykite žodžius, kad gautumėte naują reikšmę.

Google Ištroškusių nebėra. Viena, aukštuomenę reikia žiauriai nugalėti iki galo. Skiltyje User-agent turite parašyti:

- Googlebot;

- „Googlebot-Image“ – kaip jūs apsupate vaizdo indeksavimą;

- Googlebot-Mobile – skirta mobiliajai svetainės versijai.

Kaip patikrinti failo robots.txt galiojimą

Galite dirbti „Google“ paieškos variklio skiltyje „Tools for Webmasters“ arba „Yandex.Webmaster“ svetainės skiltyje „Patikrinti robots.txt“.

Jei yra klaidų, ištaisykite jas ir vėl apverskite. Norėdami pasiekti gerą rezultatą, nepamirškite nukopijuoti teisingo kodo į robots.txt ir įkelti jį į svetainę.

Dabar galite pamatyti, kaip sukurti robots.txt visoms paieškos sistemoms. Rekomenduoju žmonėms, kurie yra nauji bendruomenės nariai, pakeitę baigtą failą, pateikdami savo svetainės pavadinimą.

Gedimai