Teri blogi bu diskning isbotini beradi. Shuning uchun pokey sanoatiga yangi kelganlar ko'pincha adashadi, shuning uchun u quyidagicha bo'ladi:

Qanday robotli ex ti?

Fayl robots.txt yoki yana Indeks fayli— UTF-8 da kodlangan asosiy matn hujjati http, https, shuningdek, FTP protokollari uchun mos keladi. Fayl qidiruv robotlariga quyidagilar uchun beriladi: qaysi sahifalar/fayllar skanerlanadi. Agar faylda UTF-8 emas, balki boshqa kodlashda belgilar mavjud bo'lsa, qidiruv robotlari ularni noto'g'ri qayta ishlashi mumkin. robots.txt faylida keltirilgan qoidalar xost, protokol va fayl joylashgan port raqamiga qarab amal qiladi.

Fayl asosiy matn hujjati shaklida ildiz katalogiga o'rnatilishi kerak va unga quyidagi manzilda kirish mumkin: https://site.com.ua/robots.txt.

Boshqa fayllarda BOM (bayt tartibi belgisi) belgisini qo'yish odatiy holdir. Bu ma'lumotni o'qishda baytlardagi ketma-ketlikni ko'rsatish uchun ishlatiladigan Unicode belgisidir. Kod belgisi U+FEFF. robots.txt faylidagi bayt ketma-ketligi belgisi e'tiborga olinmaydi.

Google robots.txt faylining hajmiga cheklovlar qo'ydi - siz 500 KB dan ortiq faylni kiritishingiz shart emas.

Garazd, sizga ba'zi texnik tafsilotlar kerak bo'lgani uchun, robots.txt fayli Beckus-Naur shaklida (BNF) tasvirlangan. Bunday holda, RFC 822 qoidalari ko'rib chiqiladi.

robots.txt faylidan qoidalarni tahlil qilishda qidiruv robotlari uchta ko'rsatmalardan birini chiqaradi:

- shaxsiy kirish: saytning boshqa elementlarini skanerlash mavjud emas;

- universal kirish: hamma narsani skanerlash mumkin;

- to'liq panjara: robot hech narsani skanerlay olmaydi.

robots.txt faylini skanerlashda robotlar quyidagi turdagi javoblarni aniqlaydi:

- 2xx - skanerlash muvaffaqiyatli o'tdi;

- 3xx Ovozli robot ma'lumotlarni qayta yo'naltirishni kuzatib boradi, lekin boshqa kirishlarni rad etmaydi. Ko'pincha robotning 3xx chizig'ini olishi uchun beshta sinov mavjud, keyin 404 xatosi qayd etiladi;

- 4xx - Qidiruv roboti butun saytni skanerlashingiz mumkinligini qadrlaydi;

- 5xx - o'z vaqtida server nosozliklari sifatida baholanadi, skanerlash butunlay bloklanadi. Robot boshqa kiritishni rad etgunga qadar faylni aylanib chiqishda davom etadi. Google qidiruv roboti saytdagi turli sahifalar chiqishi toʻgʻri yoki notoʻgʻri sozlanganligini aniqlashi mumkin, shuning uchun sahifa 404 ta javob oʻrniga 5xx versiyasini ishlab chiqaradi, bu holda sahifa 404 qator kodi bilan qoʻngʻiroq qilish boʻladi.

Robots.txt fayli qanday yaratilgani hozircha noma'lum, bu faylga Internetga kirish bilan bog'liq server muammolari tufayli kirish imkoni yo'q.

Nihoyat, kerakli robots.txt fayli

Misol uchun, ba'zida robotlar etkazib berishda yaxshi emas:

- saytdagi mijozlar haqida maxsus ma'lumotlarga ega sahifalar;

- axborot almashishning turli shakllariga ega sahifalar;

- veb-sayt oynalari;

- qidiruv natijalari bilan sahifalar.

Muhim: sahifa robots.txt faylida joylashganligi sababli, saytda yoki tashqi resursda xabar topilgan bo'lsa, xavfsiz tarzda paydo bo'lishi mumkin.

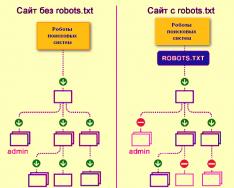

Qidiruv mexanizmi robotlari robots.txt fayli bo'lgan yoki bo'lmagan veb-saytni shunday skanerlaydi:

Robots.txt bo'lmasa, uchinchi shaxslardan olingan ma'lumotlar ko'zdan yo'qolishi mumkin va bu orqali siz va sayt zarar ko'rasiz.

Qidiruv tizimlarining roboti robots.txt faylini shunday yuklab oladi:

Google saytdagi robots.txt faylini aniqladi va saytdagi sahifalarni skanerlash qoidalarini biladi

robots.txt faylini qanday yaratish mumkin

Bloknot, bloknot, Sublime yoki boshqa matn muharriridan foydalaning.

Foydalanuvchi-agent - robotlar uchun tashrif qog'ozi

Foydalanuvchi-agent - robots.txt faylida tasvirlangan ko'rsatmalarga rioya qilish kerak bo'lgan robotlar haqidagi qoida. Hozirda 302 ta qidiruv robotlari ko'rinib turibdi

Keling, barcha qidiruv robotlari uchun robots.txt qoidalarini belgilaydiganlar haqida gapiraylik.

Google uchun asosiy robot Googlebot hisoblanadi. Agar biz boshqa biror narsani himoya qilmoqchi bo'lsak, fayl yozuvi quyidagicha bo'ladi:

Bunday holda, barcha boshqa robotlar bo'sh robots.txt faylini qayta ishlash bo'yicha o'z direktivalari asosida tarkibni skanerlaydi.

Yandex uchun asosiy robot... Yandex:

Boshqa maxsus robotlar:

- Mediapartners-Google- AdSense xizmati uchun;

- AdsBot-Google- butun tomonning ramkasini tekshirish uchun;

- Yandex rasmlari- Yandex.Images indeksi;

- Googlebot-Image- Rasmlar uchun;

- YandexMetrika- Yandex.Metrica roboti;

- YandexMedia- multimedia ma'lumotlarini indekslovchi robot;

- YaDirectFetcher- Yandex.Direct roboti;

- Googlebot-Video- Video uchun;

- Googlebot-Mobile- mobil versiya uchun;

- YandexDirectDyn- dinamik bannerlarning robot avlodi;

- YandexBloglar- Robot postlar va sharhlarni indekslaydigan bloglarni qidiradi;

- YandexMarket- Yandex.Market roboti;

- Yandex News- Yandex.Novin roboti;

- YandexDirect— tegishli reklamani tanlash uchun ularning mavzularini aniqlashtirish maqsadida Reklama OAVlarining hamkor saytlari mazmuni haqida ma’lumotlarni to‘playdi;

- Yandex sahifa tekshiruvi- mikro-marking validator;

- Yandex kalendar- Yandex.Calendar roboti.

Ruxsat bermaslik - maqsadni belgilash

Biz bundan ehtiyot bo'lamiz, chunki sayt yakunlanish bosqichida va siz uning hech qanday tarzda oshkor etilishini xohlamaysiz.

Koristuvachlar tomonidan buzilganidan oldin sayt tayyor bo'lsa, bu qoidani bilish muhimdir. Afsuski, ko'plab veb-ustalar buni unutishadi.

dumba. Robotlar papka o'rniga tavsiya etilgan sanaga qaramasligi uchun "Ruxsat bermaslik" qoidasini qanday yozish kerak /papka/:

Bu qator kengaytmalar.gif bilan barcha fayllarni indekslashni bloklaydi

Ruxsat berish - robotlarni boshqarish

Ruxsat berish har qanday faylni/direktivani/tomonni skanerlash imkonini beradi. Robotlar faqat /katalogsiz boshlangan sahifalarni ko'rishi va kontentni yopishi mumkin, lekin zarur. Qaysi tur uchun quyidagi kombinatsiya buyuriladi:

Ruxsat berish va taqiqlash qoidalari URL prefiksi (eng kichikdan kattagacha) bo'yicha saralanadi va ketma-ket tartibga solinadi. Agar sahifa o'nlab qoidalar uchun mos bo'lsa, robot tartiblangan ro'yxatdan qolgan qoidani tanlaydi.

Xost - oyna saytini tanlang

Xost robots.txt uchun majburiy qoidalardan biri bo'lib, u Yandex robotiga ko'zgu saytini indekslash uchun ishlatish kerakligini ma'lum qiladi.

Saytning oynasi - saytning aniq yoki aniq nusxasi, turli manzillarda mavjud.

Saytda ko'zgu mavjud bo'lsa robot sarson bo'lmaydi va ko'zgu robots.txt faylida ko'rsatilganligi aniq. Sayt manzillari http:// prefiksisiz kiritilishi kerak; aks holda, agar sayt HTTPS da ishlayotgan bo'lsa, https:// prefiksi ko'rsatilishi kerak.

Ushbu qoidani qanday yozish kerak:

robots.txt fayliga misol, chunki sayt HTTPS protokolida ishlaydi:

Sayt xaritasi - tibbiy sayt xaritasi

Sayt xaritasi robotlarga indekslashni talab qiladigan saytdagi barcha URL manzillar joylashganligi haqida xabar beradi http://site.ua/sitemap.xml. Terini skanerlash paytida robot ushbu faylga qanday o'zgarishlar kiritilganidan xabardor bo'ladi va qidiruv tizimining ma'lumotlar bazalarida sayt haqidagi ma'lumotlarni tezda yangilaydi.

Crawl-delay - zaif serverlar uchun sekundomer

Crawl-delay - bu sayt sahifalarini skanerlash davrini belgilash imkonini beruvchi parametr. Agar zaif serveringiz bo'lsa, bu qoida ko'proq mos keladi. Bunday holda, sayt tomonida qidiruv robotlarini joylashtirishda katta muammolar bo'lishi mumkin. Ushbu parametr soniyalarda o'zgaradi.

Clean-param - takrorlanadigan tarkibga g'amxo'rlik qilish.

Clean-param turli dinamik manzillarda (tasmalardan) mavjud bo'lishi mumkin bo'lgan kontentning takrorlanishini oldini olish uchun get-parametrlari bilan ishlashga yordam beradi. Bunday manzillar sayt turli xil tartiblash, sessiya identifikatorlari va boshqalarga ega bo'lganligi sababli paydo bo'ladi.

Yon quyidagi manzillarda mavjud bo'lishi mumkin:

www.site.com/catalog/get_phone.ua?ref=page_1&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_2&phone_id=1

www.site.com/catalog/get_phone.ua?ref=page_3&phone_id=1

Bunday holda, robots.txt fayli quyidagicha ko'rinadi:

Bu yerga ref bildirishnoma yuborilganligini bildiradi, u sahifaning o'zida yoziladi va keyin manzil ko'rsatiladi.

Malumot fayliga o'tishdan oldin siz robots.txt faylini yozishda qo'llaniladigan ba'zi belgilarni bilishingiz kerak.

robots.txt-dagi belgilar

Fayl uchun asosiy belgilar "/, *, $, #" dir.

Qo'shimcha yordam uchun slash "/" Biz robotlar bilan nimani qamrab olishni xohlayotganimizni ko'rsatamiz. Misol uchun, agar Ruxsat bermaslik qoidasida bitta chiziq bo'lsa, u butun saytni skanerlashdan saqlaydi. Ikki chiziqdan foydalanib, siz istalgan boshqa katalogni skanerlashni bloklashingiz mumkin, masalan: /katalog/.

Bunday yozuv biz katalog katalogiga to'liq skanerdan o'tkazishimizni anglatadi va agar biz /katalog deb yozsak, saytdagi /katalog bilan boshlanadigan barcha xabarlarni bloklaymiz.

Zirochka "*" fayldagi belgilar ketma-ketligini bildiradi. Teri qoidasidan keyin qo'yish kerak.

Ushbu yozuv barcha robotlar /catalog/ papkasida .gif kengaytmali fayllarni indekslashda aybdor emasligini ko'rsatadi.

dollar belgisi «$» yulduz belgisi bilan o'ralgan. Agar siz butun katalog papkasini himoya qilishingiz kerak bo'lsa, aks holda siz /catalog kabi URL manzillarini himoya qila olmaysiz, indeks faylidagi yozuv quyidagicha bo'ladi:

“#” kiriting Webmaster o'zini boshqa webmasterlardan mahrum qiladigan sharhlar uchun Vikorist. Robot saytni skanerlash uchun javobgar emas.

Masalan:

Ideal robots.txt nimaga o'xshaydi

Fayl indekslash uchun saytga yuklanadi, xost ro'yxatga olinadi va qidiruv tizimlariga indekslanishi mumkin bo'lgan manzillarni olish imkonini beruvchi sayt xaritasi taqdim etiladi. Yandex uchun qoidalar aniq ko'rsatilgan, chunki hamma robotlar Xost ko'rsatmalarini tushunmaydi.

Faylni o'zingizga nusxalashga shoshilmang - har bir sayt sayt turiga va CMSga qarab o'ziga xos qoidalarga ega bo'lishi mumkin. Shuning uchun, robots.txt faylini to'ldirishda barcha qoidalarni eslab qolishingiz kerak.

robots.txt faylini qanday tekshirish mumkin

Agar robots.txt faylini toʻgʻri toʻldirganingizga ishonch hosil qilishni istasangiz, uni Webmaster Tools-da tekshiring. Google va Yandex. Taqdim etish shaklidagi robots.txt fayliga chiqish kodini kiriting va tekshirilayotgan saytni ko'rsating.

robots.txt faylini qanday saqlash kerak

Ko'pincha, indeks faylini to'ldirishda sekretsiyalarga ruxsat beriladi va bu haddan tashqari hurmatsizlik yoki shoshqaloqlik bilan bog'liq. Men amalda o'rgangan kechirim jadvalidan bir necha barobar pastroq.

2. Bitta “Ruxsat bermaslik” ko‘rsatmasida bir nechta papkalarni/kataloglarni yozib olish:

Bunday ro'yxatga olish ovozli robotlarni chalkashtirib yuborishi mumkin, ular o'zlari indekslanmasligi kerakligini tushunmasliklari mumkin: men papkani boshlaymanmi yoki uni tark etamanmi, diqqat bilan teri qoidasini yozishim kerak.

3. Faylning o'zi chaqirilishi mumkin faqat robots.txt, va Robots.txt, ROBOTS.TXT yoki boshqa yo'l emas.

4. User-agent qoidasini bekor qilish mumkin emas - faylda yozilgan qoidalarni o'zgartirish uchun qaysi robot javobgarligini aytish kerak.

5. Fayldan belgilarni himoya qilish (qiyshiq chiziq, yulduzcha).

6. Indeksda bo'lishi shart bo'lmagan sahifalarni faylga qo'shish.

Nostandart robots.txt

To'g'ridan-to'g'ri funktsiyalaridan tashqari, indeks fayli ijodkorlik manbai va yangi ko'ngillilarni topish usuliga aylanishi mumkin.

Bu robots.txt ning o'zi ishlaydigan elementlar va reklama blokiga ega kichik sayt bo'lgan sayt.

Soxta narsalarni qidirish uchun maydanchik sifatida fayl asosan SEO agentliklari tomonidan vikoristlanadi. Sizning orzuingiz haqida yana kim bilishi mumkin? :)

Va Google maxsus faylni saqlaydi humans.txt Fahivlarni terisi va go'shti uchun kamsitish haqidagi fikrlarga yo'l qo'ymaslik uchun.

Visnovki

Robots.txt yordamida siz robotlarni qidirish, o'zingizni, brendingizni reklama qilish va mutaxassislarni prank qilish bo'yicha ko'rsatmalar berishingiz mumkin. Bu tajriba uchun ajoyib maydon. Golovniy, faylni to'g'ri to'ldirish va standart tozalash haqida unutmang.

Qoidalar, ular robots.txt fayliga ko'rsatmalar hidi, ko'rsatmalar hidi:

- Foydalanuvchi-agent - bu robots.txt-da tasvirlangan ko'rsatmalarga amal qilishi kerak bo'lgan robotlar haqidagi qoida.

- Ruxsat bermaslik ma'lumotlarning o'zini skanerlash mumkin emasligi haqidagi tavsiyani bildiradi.

- Sayt xaritasi robotlarga indekslashni talab qiladigan barcha sayt URL manzillari http://site.ua/sitemap.xml manzilida joylashganligi haqida xabar beradi.

- Xost Yandex robotiga ko'zgu saytini indekslash uchun yollash kerakligi haqida xabar beradi.

- Ruxsat berish har qanday faylni/direktivani/tomonni skanerlash imkonini beradi.

robots.txt katlama belgilari:

- Dollar belgisi "$" yulduz belgisi bilan o'ralgan.

- "/" slashdan keyin biz robotlar tomonidan aniqlashdan yashirmoqchi bo'lgan narsalarni ko'rsatamiz.

- Yulduzcha "*" fayldagi belgilar ketma-ketligini bildiradi. Teri qoidasidan keyin qo'yish kerak.

- “#” xeshi veb-ustaning o'zi yoki boshqa veb-ustalar uchun yozgan sharhlarini belgilash uchun ishlatiladi.

Indeks faylini donolik bilan tekshiring - va kelajakda sayt ko'rinadigan bo'ladi.

O'qish soati: 7 hwilin

Bizga audit yoki tekshirish uchun kelgan deyarli har bir loyihada noto'g'ri robots.txt fayli va ko'pincha butun kun davomida mavjud. Shunday qilib, fayl yaratilganda, hamma qoidalarga emas, balki o'z tasavvuriga asoslanadi. Keling, qidiruv robotlari u bilan samarali ishlashi uchun ushbu faylni qanday qilib to'g'ri yig'ish kerakligini aniqlaylik.

robots.txt faylini yaxshilash kerakmi?

Robots.txt- bu fayl qidiruv tizimi roboti tomonidan xabar qilingan ildiz katalozi saytida joylashgan bo'lib, ular saytning qaysi bo'limlari va sahifalariga kirishni rad etishlari mumkin, ammo kirish imkoni yo'q.

robots.txt-ni sozlash qidiruv tizimi tizimlari uchun muhim qismdir; robotlarni to'g'ri sozlash ham sayt unumdorligini oshiradi. Robots.txt mavjudligi qidiruv tizimlariga saytni skanerlash va indekslash imkonini bermaydi, lekin agar sizda bu fayl bo'lmasa, ikkita muammoga duch kelishingiz mumkin:

Qidiruv roboti butun saytni o'qiydi, shuning uchun u emaklash byudjetini "supurib tashlaydi". Qidiruv roboti bir soat ichida navigatsiya qila oladigan darajada ko'p saytlarni skanerlash byudjeti.

Robotlar fayli bo'lmasa, qidiruv tizimi CMS boshqaruvi uchun ishlatiladigan yuzlab sahifalargacha qora va oq sahifalarga kirishni rad etadi. U ularni indekslaydi va agar siz o'ng tarafdagi to'g'ri sahifalarga o'tsangiz, unda nashriyotchilar uchun eng muhim kontent taqdimotlari o'tkaziladigan byudjet tugaydi.

Indeks saytga kirish sahifasidan va boshqa administrator resurslaridan foydalanishi mumkin, shuning uchun tajovuzkor ularga osongina kirishi va DDoS hujumini yoki saytga zararli dasturlarni amalga oshirishi mumkin.

Saytni robots.txt-dan foydalanib va unsiz yuklab olish uchun robotlarni qanday qidirish kerak:

Robots.txt sintaksisi

Birinchidan, sintaksisni tushunishni boshlang va "ideal fayl" qanday ko'rinishiga qarab robots.txt-ni sozlang:

Ale ne varto razu z yogo zastosovuvati. Har bir sayt uchun ko'pincha o'ziga xos sozlashlarga ega bo'lish kerak, chunki bizda har xil sayt tuzilishi, turli CMS mavjud. Keling, teri direktivasini tartibda olaylik.

Foydalanuvchi-agent

User-agent - faylda tasvirlangan ko'rsatmalarga amal qilishi kerak bo'lgan qidiruv robotini anglatadi. Agar siz birdaniga hammaga qaytishingiz kerak bo'lsa, * belgisi paydo bo'ladi. Shuningdek, siz qo'shiq ovozli robotga o'tishingiz mumkin. Masalan, Yandex va Google:

Direktivning qo'shimcha maqsadi uchun robot qaysi fayl va papkalarni indekslash bloklanganligini tushunadi. Agar butun saytingiz indekslash uchun ochiq boʻlishini istasangiz, “Ruxsat berish” qiymatini boʻsh qoldiring. Taqiqlashdan keyin saytdagi barcha kontentni qabul qilish uchun “/” belgisini qo'ying.

Biz qo'shiq papkasi, fayl yoki fayl kengaytmasiga kirishni bloklashimiz mumkin. Bizning ilovamiz barcha qidiruv tizimlarini yopadi, bitrix, qidiruv va pdf papkalariga kirishni bloklaydi.

Ruxsat bering

Sayt sahifalari va bo'limlarini indekslash uchun Primus-ning ochilishiga ruxsat bering. Ilovada biz Google qidiruv robotlariga o'tamiz, bitrix papkasiga, qidiruv va pdf kengaytmasiga kirishni bloklaymiz. Bitrix papkasida biz indekslash uchun 3 ta papkani ochamiz: komponentlar, js, asboblar.

Xost - ko'zgu sayt

Oynali sayt asosiy saytning dublikatidir. Ko'zgular turli maqsadlarda qo'llaniladi: manzilni o'zgartirish, xavfsizlik, serverdagi trafikni kamaytirish va boshqalar.

Xost eng muhim qoidalardan biridir. Agar bu qoida yozilgan bo'lsa, robot indekslash uchun qabul qilinishini saytning ko'zgularidan ekanligini tushunadi. Ushbu direktiv Yandex va Mail.ru robotlari uchun zarur. Boshqa robotlar odatda e'tiborga olinmaydi. Xost faqat bir marta ro'yxatdan o'tishi kerak!

"https://" va "http://" protokollari uchun robots.txt faylining sintaksisi boshqacha bo'ladi.

Sayt xaritasi - sayt xaritasi

Sayt xaritasi qidiruv tizimlarini yangi sahifalar haqida xabardor qilish uchun foydalaniladigan sayt navigatsiyasi shaklidir. Qo'shimcha sayt xaritasi yo'riqnomasidan so'ng, biz robotga xarita o'chirilganligini "majburiy" ko'rsatamiz.

robots.txt-dagi belgilar

Faylda paydo bo'ladigan belgilar: "/, *, $, #".

robots.txt ni sozlagandan so'ng jarayonning samaradorligini tekshirish

Robots.txt-ni veb-saytingizga joylashtirganingizdan so'ng, uni Yandex va Google veb-ustasi bilan qo'shishingiz va tasdiqlashingiz kerak.

Yandex tekshiruvi:

- Ko'rsatmalarga amal qiling.

- Tanlang: Sozlangan indekslash – robots.txt tahlili.

Google tekshiruvi:

- Ko'rsatmalarga amal qiling.

- Tanlang: Scan - robots.txt faylini tekshirish vositasi.

Shu tarzda siz robots.txt faylida o'zgarishlar mavjudligini tekshirishingiz va kerak bo'lganda kerakli o'zgarishlarni amalga oshirishingiz mumkin.

- Fayl o'rniga katta harflar bilan yozish kerak.

- Disallow direktivasi kamida bitta fayl yoki katalogni ko'rsatishni talab qiladi.

- "Foydalanuvchi-agent" qatori bo'sh bo'lishi shart emas.

- Foydalanuvchi-agent har doim ruxsat berishdan oldin borishi mumkin.

- Agar siz katalogni indeksatsiyadan himoya qilishingiz kerak bo'lsa, chiziq chizig'ini qo'shishni unutmang.

- Faylni serverga yuklashdan oldin uni sintaktik va imlo xatolariga tekshirish kerak.

Sizga omad!

Robots.txt faylini yaratish va sozlashning 3 usulini video ko'rib chiqish

Biz "Ijtimoiy tarmoqlarda kontent marketingi: qanday qilib oldindan to'lovchilar boshiga kirib, ularni o'z brendingiz bilan chalkashtirib yuborish kerak" nomli yangi kitobni nashr qildik.

Xost direktivasi qidiruv tizimiga muhim bo'lganlar (www bilan yoki wwwsiz) haqida ma'lumot beruvchi buyruq yoki qoidadir. Ko'rinishidan, faylning Xost direktivasi faqat Yandex-ga tayinlangan.

Ko'pincha qidiruv tizimi sizning ko'zgu saytingiz sahifalarini indekslamasligiga ishonch hosil qilish kerak. Masalan, resurs bitta serverda joylashgan, lekin Internetda u qidiruv natijalarini indekslash va ko'rsatish uchun mas'ul bo'lgan domen nomi bilan bir xil.

Yandex qidiruv robotlari veb-saytlarning tomonlarini chetlab o'tadi va to'plangan ma'lumotlarni joriy jadval orqasida ma'lumotlar bazasiga qo'shadi. Indekslash jarayonida muammolar o'z-o'zidan paydo bo'ladi, qaysi tomonni qayta ishlash kerak. Masalan, robotlar turli forumlardan, qidiruv tizimlaridan, kataloglardan va boshqa manbalardan qochishlari, chalkashmasdan indeksatsiya qilishlari kerak. Xuddi shu hidni asosiy sayt va oynada topish mumkin. Birinchilari indekslashni targ'ib qiladi, boshqalari esa yo'q. Jarayon ko'pincha muammolarga duch keladi. Markazda Robots.txt faylida Xost direktivasidan foydalanishingiz mumkin.

Bu yerda kerakli Robots.txt fayli

Robotlar odatiy matn faylidir. Siz uni Notepad yordamida yaratishingiz mumkin, Notepad++ matn muharriri yordamida u bilan ishlashingiz mumkin (ma'lumotni ochish va tahrirlash). Veb-resurslarni optimallashtirishda faylga bo'lgan ehtiyoj bir necha omillar bilan belgilanadi:

- Agar Robots.txt fayli chop etilsa, veb-saytga ovozli mashinalar robotlari orqali doimiy ravishda qayta tashrif buyuriladi.

- Barcha sahifalar va aks ettiruvchi saytlar indekslanishi aniq.

Indekslash ancha tezroq bo'ladi va sozlamalar noto'g'ri o'rnatilgan bo'lsa, siz Google va Yandex qidiruv natijalarida yo'qolishingiz mumkin.

Robots.txt faylida Xost direktivasi qanday formatlanadi

Robotlar faylida Xost direktivasi mavjud - qidiruv tizimi uchun asosiy sayt va oyna haqidagi ko'rsatmalar.

Direktiv quyidagi ko'rinishda yoziladi: Xost: [til bo'lmagan holda] [ma'nosi] [til bo'lmagan holda]. Direktivlarni yozish qoidalari quyidagi bosqichlarni talab qiladi:

- HTTPS protokoliga xos bo'lgan direktiv shifrlashni qo'llab-quvvatlaydi. Buni tuzatish kerak, chunki oynaga kirish o'g'irlangan kanal bilan cheklangan.

- IP manzili bo'lmagan domen nomi, shuningdek, veb-resursning port raqami.

Veb ustasiga ovozli mashinalar de smut dzerkalo uchun ma'lumot berishga ruxsat beruvchi ko'rsatma to'g'ri tuzilgan. Boshqalar boshqalar tomonidan hurmat qilinadi va shuning uchun indekslanmaydi. Qoida tariqasida, nometall www qisqartmasi mavjudligi yoki yo'qligi bilan ajralib turishi mumkin. Muxbir hatto Xost yordamida veb-resursni aks ettirmaganligi sababli, Yandex qidiruv tizimi Webmasterdan eng yaxshi ma'lumot manbai edi. Agar Robotlar faylida o'ta sezgir Xost direktivasi bo'lsa, xuddi shunday bildirishnoma yuboriladi.

Ahamiyati, de golovne dzerkalo sayt qidiruv tizimi orqali mumkin. Qidiruv qatoriga resurs manzilini kiritishingiz va natijalarga qarashingiz kerak: manzil qatoridagi domen oldida www va bosh domen joylashgan sayt.

Resurs ko'rinish tomonida ko'rsatilmasa, foydalanuvchilar Yandex.Webmaster-dagi ikkinchi darajali bo'limga o'tish orqali uni mustaqil ravishda bosh oynasi sifatida tanib olishlari mumkin. Veb-master saytning domen nomi www-ni noto'g'ri joylashtirmasligini ta'minlashi kerakligi sababli, u Xost tomonidan ko'rsatilmasligi kerak.

Ko'pgina veb ustalari o'z saytlari uchun qo'shimcha oyna sifatida kirill domenlaridan foydalanadilar. Biroq, Xost direktivasi kirill alifbosini qo'llab-quvvatlamaydi. Buning uchun lotin tilidagi so‘zlarni ko‘paytirish kerak, shunda ular manzillar qatoridan sayt manzilini ko‘chirish orqali osongina tanib olinadi.

Robotlar faylida xost

Ushbu yo'riqnomaning asosiy maqsadi ikki nusxadagi muammolarning ko'pchiligidadir. Xostni tartiblash kerak, chunki veb-resurs rus auditoriyasiga qaratilgan va, ehtimol, saytni saralash Yandex tizimi tomonidan amalga oshirilishi mumkin.

Hamma ovoz tizimlari Xost direktivasini qo'llab-quvvatlamaydi. Funktsiya faqat Yandex-da mavjud. Biroq, domen oyna tasviri sifatida tayinlanishiga kafolat yo'q, lekin Yandexning o'zi aytganidek, ustuvorlik har doim xostda ko'rsatilgan nomlarga yo'qoladi.

Qidiruv tizimlari robots.txt faylini qayta ishlashda ma'lumotni to'g'ri o'qishi uchun foydalanuvchi-agentdan keyin boshlanadigan tegishli guruhga Xost direktivasini qo'shish kerak. Biroq, robotlar ko'rsatma mamlakat qoidalariga muvofiq yozilgan bo'lishidan qat'i nazar, Xostni vikorizatsiya qilishlari mumkin, agar u kesma bo'lsa.

Biz "Ijtimoiy tarmoqlarda kontent marketingi: qanday qilib oldindan to'lovchilar boshiga kirib, ularni o'z brendingiz bilan chalkashtirib yuborish kerak" nomli yangi kitobni nashr qildik.

Robots.txt - bu portal sahifalarini indekslashga yordam beruvchi qidiruv robotlari uchun ko'rinishlarni o'z ichiga olgan matnli fayl.

Kanalimizda ko'proq videolar - SEMANTICA dan internet marketingni o'rganing

![]()

Orolga narsalaringizni olish uchun borganingizni oshkor qiling. Siz xarita chizasiz. U erda marshrut ko'rsatilgan: “Buyuk dashtga boring. Chiqishda 10 krok topish bilan boshlang, keyin darajaga o'ting. O‘ng qo‘l bilan buriling, pechera topasiz”.

Tse - vkazivki. Ularga ergashib, siz marshrutni kuzatib borasiz va xazinalar topasiz. Taxminan qidiruv boti sayt yoki tomonni indekslashni boshlaganda ishlaydi. Siz robots.txt faylini bilishingiz kerak. Qaysi sahifalar indekslanishi kerakligini va qaysi biri yo'qligini hamma biladi. Va ushbu buyruqlarga rioya qilib, siz portalni chetlab o'tasiz va uning sahifalarini indeksga qo'shasiz.

Nima uchun sizga robots.txt kerak?

Ular sayt hosting va ro'yxatdan o'tgan DNS so'rovlaridan so'ng saytlar va indeks sahifalariga tashrif buyurishni boshlaydilar. Texnik fayllaringiz bo'lmasa ham, ishingiz ustida ishlashni to'xtatish muhimdir. Robotlar pranksterlarga veb-saytni skanerlashda undagi parametrlarni saqlash kerakligini ko‘rsatib berishadi.

robots.txt faylining mavjudligi saytni skanerlash tezligi va indeksda sayt mavjudligi bilan bog'liq muammolarni keltirib chiqarishi mumkin. Faylni to'g'ri sozlamaslik indeksdan manbaning muhim qismlarini kiritish va keraksiz sahifalar mavjudligiga olib kelishi mumkin.

Bularning barchasi, natijada, oqish bilan bog'liq muammolarga olib keladi.

Keling, ushbu faylda qanday qo'shimchalar joylashganligini va ular robotning veb-saytingizdagi xatti-harakatlariga qanday ta'sir qilishini bilish uchun hisobotni ko'rib chiqaylik.

Yak zrobiti robots.txt

Birinchidan, qaysi faylingiz borligini tekshiring.

Brauzerning manzil satriga veb-sayt manzilini va fayl nomini slash orqali kiriting, masalan, https://www.xxxxx.ru/robots.txt

Agar fayl mavjud bo'lsa, ekranda parametrlar ro'yxati paydo bo'ladi.

Faylda quyidagilar mavjud emas:

- Fayl Notepad yoki Notepad++ kabi asosiy matn muharriri yordamida yaratiladi.

- Siz robotlar nomini o'rnatishingiz kerak, extension.txt. Qabul qilingan dizayn standartlariga muvofiq ma'lumotlarni kiriting.

- Yandex webmaster kabi qo'shimcha xizmatlar uchun imtiyozlarni tekshirishingiz mumkin. U erda siz "Asboblar" bo'limida "Analize robots.txt" bandini tanlashingiz va ko'rsatmalarni bajarishingiz kerak.

- Fayl tayyor bo'lgach, uni saytning asosiy katalogiga yuklang.

O'rnatish qoidalari

Jokerlarda bir nechta robot bor. Ba'zi robotlar faqat matn tarkibini indekslaydi, robotlar esa faqat grafik tarkibni indekslaydi. Ovoz tizimlarining o'zida robotli skanerlarning bir xil sxemasi boshqacha bo'lishi mumkin. Faylni yig'ishda uni mahkamlash kerak.

Ularning operatorlari ba'zi qoidalarni e'tiborsiz qoldirishlari mumkin, masalan, GoogleBot saytni boshida aks ettiradiganlar haqidagi ma'lumotlarga javob bermaydi. Umuman olganda, badbo'y hid tutiladi va fayl bilan saqlanadi.

Fayl sintaksisi

Hujjat parametrlari: robot nomi "Foydalanuvchi-agent", direktivalar: alohida xususiyat "Ruxsat berish" va xavfsizlik "Ruxsat berish".

Ikkita asosiy qidiruv tizimi mavjud: Yandex va Google.Shubhasiz, veb-sayt yaratishda ikkalasidan ham foydalanish muhim.

Yozuvlarni yaratish formati maydonlar va bo'sh qatorlarda hurmat ko'rsatish uchun shunday ko'rinadi.

Foydalanuvchi-agent direktivasi

Robot User-agent bilan boshlanadigan yozuvlarni qidiradi va qidiruv robotining nomi uchun yozuvlar mavjud. Bu ko'rsatilmagan bo'lsa-da, robotga kirish cheklanmagan bo'lishi muhimdir.

Direktivlar ruxsat bermaslik va ruxsat berish

Agar siz robots.txt dan indekslashni bloklashingiz kerak bo'lsa, "Ruxsat berish" dan foydalaning. Bu robotning saytga yoki turli bo'limlarga kirishini cheklashga yordam beradi.

Robots.txt himoya qiluvchi bir xil “Ruxsat bermaslik” direktivasiga mos kelmagani uchun butun saytni indekslashga ruxsat berilishi muhim. Zazvichiy zaboroni teri robot okremo keyin tayinlanadi.

# belgisidan keyin kiritilgan barcha ma'lumotlar mashina tomonidan izoh sifatida qabul qilinmaydi.

Kirishga ruxsat berish uchun blokirovka qilishga ruxsat bering.

Yulduzcha belgisi hammani tashvishga solayotganlar uchun stenografiya bo'lib xizmat qiladi: Foydalanuvchi-agent: *.

Biroq, bu variant har bir kishi uchun indekslashni to'liq taqiqlashni anglatadi.

Men qo'shiq papkasi-katalogi o'rniga panjaraga qarayman

Bitta faylni blokirovka qilish uchun siz ushbu mutlaq yo'lni kiritishingiz kerak

Sayt xaritasi, Xost ko'rsatmalari

Yandex uchun ko'zgu kabi, siz uni shafqatsiz deb tan olishni xohlaysiz, deyish odatiy holdir. Va Google, biz eslaganimizdek, unga e'tibor bermaydi. Ko'zgular yo'qligi sababli, veb-saytingiz nomini www bilan yoki wwwsiz to'g'ri yozish qanchalik muhimligini e'tiborga oling.

Clean-param direktivasi

Agar veb-sayt sahifalarining URL manzili o'zgaruvchan parametrlarni almashtirsa, lekin ularga birlashmasa (bu hissa qo'shuvchilar, refererlar identifikatorlarini o'z ichiga olishi mumkin) ularni muzlatish mumkin.

Masalan, "ref" sahifalarining manzili trafikning maqsadini ko'rsatadi, keyin. E'tibor bering, eng yaxshi sotuvchilarning veb-saytida belgilar mavjud. Barcha mijozlar uchun sahifa bir xil bo'ladi.

Ish onlayn tarzda topshirilishi mumkin va ma'lumotlar takrorlanmaydi. Bu server yukini kamaytiradi.

Tekshirishni kechiktirish direktivasi

Bundan tashqari, siz bot sahifalarni tahlil qilish uchun qaysi chastotada jalb qilishini aniqlashingiz mumkin. Agar revantage server chetlab o'tish jarayonini tezlashtirish kerakligini ko'rsatsa, bu buyruq to'xtab qoladi.

Robots.txt so'rovlari

- Fayl ildiz katalogida mavjud emas. Eng buyuk robot hazil qilmaydi va yolg'on gapirmaydi.

- Ismdagi harflar kichik lotincha bo'lishi mumkin.

Nomida yozuv bor, ba'zan oxiriga S harfini qo'shib robot yozasiz. - Robots.txt faylida kirill harflarini o'zgartirish mumkin emas. Agar siz domenni rus tilida kiritishingiz kerak bo'lsa, formatni belgilash uchun maxsus Punycode formatidan foydalaning.

- Bu domen nomlarini ASCII belgilar ketma-ketligiga aylantirish usuli. Buning uchun siz tezda maxsus konvertorlardan foydalanishingiz mumkin.

Kod quyidagicha ko'rinadi:

site.rf = xn--80aswg.xn--p1ai

Robotlar txt-da yashirilishi va Google va Yandex qidiruv tizimlariga moslashtirilgan qo'shimcha ma'lumotlarni qo'shimcha hujjatlarda topish mumkin. Turli sms uchun ular o'ziga xos xususiyatlarga ega bo'lishi mumkin, ammo ular boshqacha bo'ladi.

izohlarsizRobots.txt fayli qidiruv robotlari uchun maxsus yaratilgan bo'lib, ular qaerga borish va indekslash va kirish bloklangan joyni bilishlari uchun. Agar siz uni noto'g'ri sozlagan bo'lsangiz, qidiruvga ko'p vaqt sarflamasligingiz yoki hech narsa qilmasligingiz mumkin.

Maqolalarni indekslash va indekslash bilan bog'liq muammolarni oldini olish uchun barcha qidiruv tizimlari uchun robotlar txt-ni qanday yaratishni bilishingiz kerak. Bu bir oz vaqtni oladi, ammo shundan keyin siz xotirjam bo'lasiz.

Veb ustalari ularsiz (asosan, dastlab, jaholat tufayli) til topishishga harakat qilishdi. Bir tomondan, bu yangi boshlanuvchilar uchun o'rinli - bu bilan siz qidiruv robotlaridan kerakli ma'lumotlarni to'sib qo'ymaysiz. Boshqa tomondan, bu kichik fayl ma'lumotlarni himoya qiladi va spam-botlarning saytdagi ma'lumotlarni ko'rishiga yo'l qo'ymaydi.

Yangi bloggerlarga shablonlardan foydalanishni tavsiya qilaman. Misol uchun, WordPress uchun robotlar txt shabloni. Saytingizni yaxshilang va yaxshilang.

Shifrlanmagan qiymat:

- Foydalanuvchi-agent: * - Siz to'g'ridan-to'g'ri barcha qidiruv tizimlariga, Yandex - faqat Yandex-ga ulangansiz.

- Ruxsat bermaslik: indekslash uchun bloklangan papkalar va fayllar ro'yxatini ko'rsatadi

- Xost – www.siz saytingiz nomini kiriting.

- Sayt xaritasi: XML sayt xaritasiga yuklash.

Faylni Filezilla yordamida yoki xosting veb-sayti orqali saytning ildiz katalogiga joylashtiring. Yetkazib berish mumkin bo'lishi uchun asosiy katalogga yuboring: your_site.ru/robots.txt

Bu, ayniqsa, CNC-dan foydalanadiganlar uchun to'g'ri keladi (ko'rsatmalar so'zlar bilan yozilgan, lekin p=333 emas). Siz qilishingiz kerak bo'lgan yagona narsa - Sozlamalar - Postname bo'limiga o'ting, pastki variantni tanlang va maydonga /% postname% kiriting.

Aktyorlarga ushbu faylni imkon qadar tezroq mustaqil ravishda yaratish tavsiya etiladi:

Boshlash uchun kompyuteringizda bloknot yarating va uni robotlar deb nomlang (katta harfni o'zgartirmang). Masalan, o'lchamingizni sozlash 500 kb dan oshmasligi kerak.

Foydalanuvchi-agent- Qidiruv tizimining nomi (Yandex, Googlebot, StackRambler). Agar siz birdaniga hammaga g'azablanmoqchi bo'lsangiz, yulduzcha qo'ying *

Va keyin yordam uchun ushbu ishda indekslanmaydigan sahifalar yoki papkalarni ko'rsating Ruxsat bermaslik:

Dastlab, ma'lum bir faylni o'z ichiga olgan uchta katalog qayta tashkil etildi.

Hamma narsani indekslashga ruxsat berish uchun quyidagilarni yozishingiz kerak:

Foydalanuvchi-agent: *

Ruxsat bermaslik:

Yandex va Google uchun robots.txt faylini sozlash

Yandex uchun Ikki nusxadagi sahifalar bo'lmasligi uchun xost direktivasini qo'shish majburiydir. Bu so'z faqat Yandex boti tomonidan tushuniladi, shuning uchun so'zlarni yangi ma'no uchun yozing.

Google uchun Yana chanqaganlar yo'q. Birinchisi, zodagonlarni oxirigacha shafqatsiz qilish kerak. User-agent bo'limida siz quyidagilarni yozishingiz kerak:

- Googlebot;

- Googlebot-Image – tasvirning indeksatsiyasini qanday o‘rab turganingiz;

- Googlebot-Mobile – saytning mobil versiyasi uchun.

robots.txt faylining haqiqiyligini qanday tekshirish mumkin

Siz Google qidiruv tizimining "Veb-ustalar uchun asboblar" bo'limida yoki Yandex.Webmaster veb-saytida robots.txt-ni tekshirish bo'limida ishlashingiz mumkin.

Agar xatolar bo'lsa, ularni to'g'rilab, yana aylantiring. Yaxshi natijaga erishish uchun robots.txt-ga to'g'ri kodni nusxalashni va uni saytga yuklashni unutmang.

Endi siz barcha qidiruv tizimlari uchun robots.txt ni qanday yaratishni ko'rishingiz mumkin. Men yangi boshlanuvchilarga saytingiz nomini taqdim etgan holda tayyor faylni vikorist qilishni tavsiya qilaman.

Buzilishlar